Steve Aoki pierde su vuelo y queda varado más de 3 horas en el nuevo aeropuerto de Perú

Una investigación reveló que Instagram y Facebook mostraron anuncios de herramientas que generan imágenes sexuales falsas de personas reales. Meta los eliminó solo tras ser expuesta.

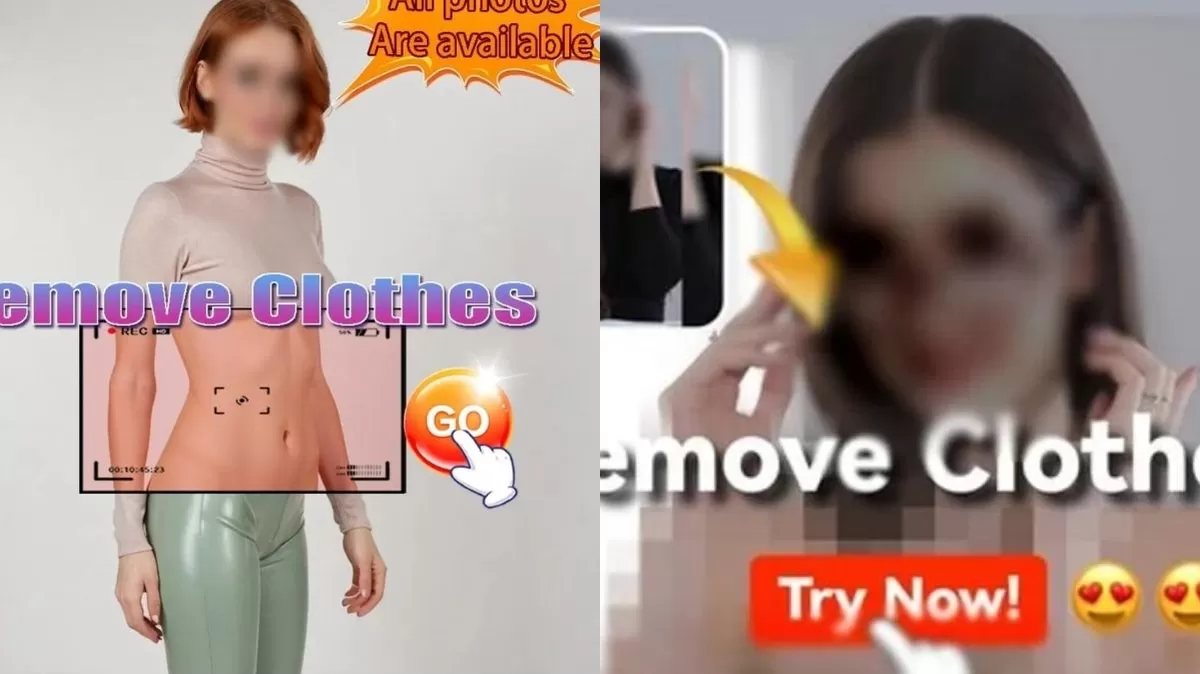

Una investigación de CBS News reveló que plataformas de Meta como Instagram y Facebook mostraron cientos de anuncios de aplicaciones con inteligencia artificial que permiten crear desnudos falsos de personas reales. Los llamados “nudify apps” ofrecían funciones para subir fotos y generar imágenes sexualizadas sin consentimiento.

Meta eliminó los anuncios tras ser contactada por CBS, afirmando tener políticas estrictas contra contenido íntimo no consensuado. Sin embargo, algunos de los anuncios seguían apareciendo incluso después de su supuesta eliminación.

Entre los casos, se detectaron anuncios usando imágenes falsas de actrices como Scarlett Johansson y Anne Hathaway, además de enlaces que dirigían a sitios donde se cobraba entre $20 y $80 por funciones avanzadas, o incluso a la App Store de Apple.

Según los datos de la biblioteca de anuncios de Meta, muchos de estos mensajes estaban dirigidos a hombres de entre 18 y 65 años, principalmente en EE. UU., Reino Unido y la Unión Europea. Los expertos aseguran que Meta no invierte lo suficiente en frenar esta amenaza.

La ley “Take It Down Act”, firmada recientemente en EE.UU., obliga a eliminar este tipo de contenido en 48 horas, pero no sanciona las herramientas que lo generan. Esto deja abierta la puerta para que estas apps se disfracen como inofensivas, a pesar de su objetivo explícito.